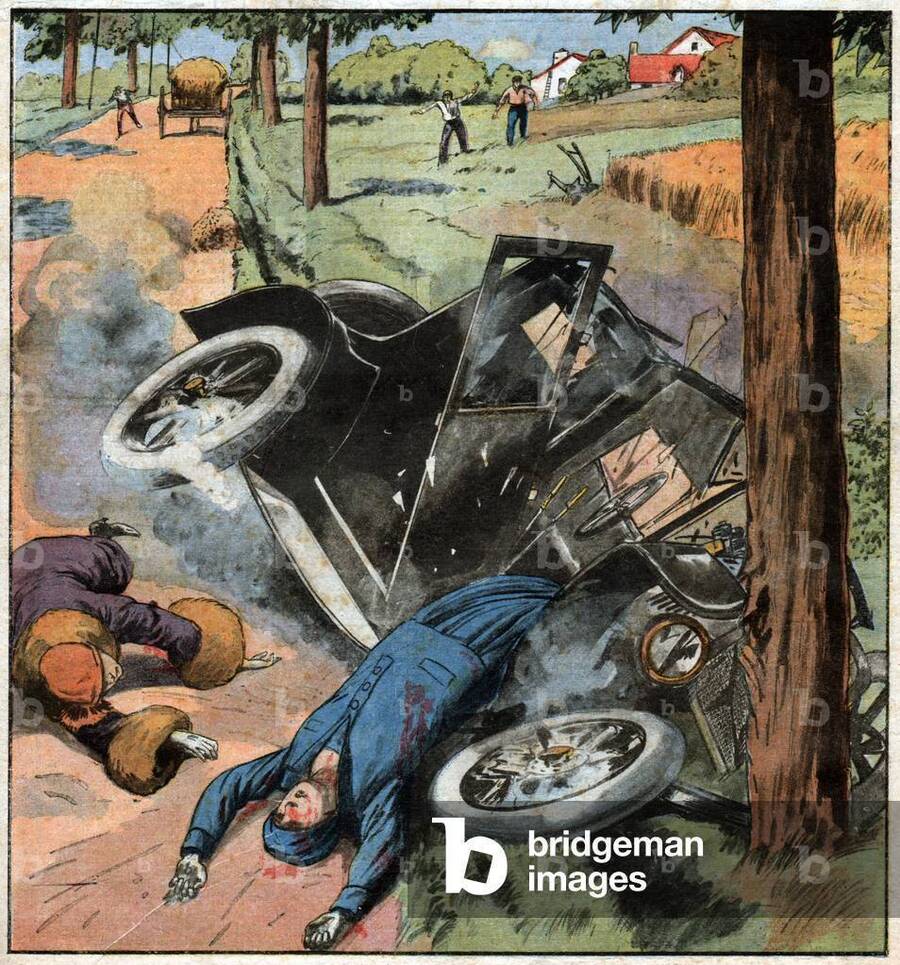

J’ai lu cette tribune d’un neurochirurgien qui compare les performances de Waymo, les voitures autonomes de Google, à celles des conducteurs humains. Et je dois avouer que les chiffres, s’ils sont exacts, donnent un petit vertige. Des dizaines de millions de kilomètres parcourus sans chauffeur dans plusieurs villes américaines, et au bout du compte beaucoup moins d’accidents graves, beaucoup moins de blessés, beaucoup moins de morts que quand c’est nous, humains, qui tenons le volant. Le médecin pousse même l’analogie avec la médecine : en recherche clinique, quand un traitement se révèle largement supérieur au placebo, on arrête l’essai. Continuer à donner du sucre à certains patients alors qu’on a une molécule qui sauve massivement plus de vies devient contraire à l’éthique. Transposé à la route, son raisonnement est brutal : laisser des humains conduire, alors qu’une intelligence artificielle tue dix fois moins de gens, deviendrait, à un moment, moralement discutable.

Sur le papier, l’argument est imparable. Si on se contente de regarder les statistiques, on pourrait presque dire que la question est réglée : on confie le volant aux machines, on encaisse la chute des morts et des blessés, et on se félicite d’avoir été rationnels. Mais c’est précisément là que le problème commence. Parce que la machine, elle, ne « panique » pas. Elle ne ferme pas les yeux, elle ne donne pas un coup de volant désespéré en espérant un miracle. Elle applique ce qu’on lui a mis dans le crâne, c’est-à-dire un ensemble de règles, de priorités, de pondérations que des humains ont écrites à l’avance. Et c’est là qu’arrive la fameuse scène, un peu cliché, mais incontournable.

La voiture roule. Une vieille dame traverse au dernier moment. Il est trop tard pour s’arrêter net, même avec les meilleurs freins et le meilleur temps de réaction du monde. Deux trajectoires se dessinent : continuer tout droit et percuter la vieille dame, ou se jeter contre un mur et exposer le passager à un choc potentiellement mortel. Quand c’est un humain qui conduit, la plupart du temps, il n’y a pas de décision éthique digne de ce nom. Il y a la peur, le réflexe, la crispation sur le volant, le pied qui écrase la pédale de frein sans savoir si ça suffira. Ce qui se passe dans le cerveau ressemble plus à un court-circuit paniqué qu’à une délibération philosophique. On agit, on subit, et après on constate les dégâts.

La société, elle, range ça dans une catégorie commode : « tragique accident ». On pleure, on s’indigne un peu, on refait la scène dans les journaux pendant deux jours, puis on repart. On ne questionne pas sérieusement la « morale » du conducteur, parce qu’on sait bien que personne ne choisit consciemment de tuer une vieille dame ou de s’écraser contre un mur. On vit avec cette part de chaos, justement parce qu’elle est humaine. C’est imparfait, c’est injuste, mais ça reste supportable psychologiquement : on appelle ça le hasard, la fatalité, la malchance.

Une voiture autonome ne fonctionne pas comme ça. Elle ne tremble pas. Elle ne perd pas ses moyens. Elle ne se dit pas « mon Dieu, qu’est-ce que je fais ? ». Elle cherche dans son espace de calcul la trajectoire qui correspond le mieux à ce qu’on lui a demandé d’optimiser. Et c’est là que la vraie question surgit : qu’est-ce qu’on lui a demandé, exactement ? De sauver coûte que coûte le passager, celui qui a accepté de monter à bord, payé son trajet, mis sa vie entre les mains du système ? De privilégier le piéton, parce qu’il est vulnérable, qu’il n’a rien demandé, qu’il n’a signé aucun contrat ? De minimiser le nombre de morts et de blessés, quitte à sacrifier une personne pour en préserver trois ? De prendre en compte l’âge, la fragilité, la situation de chacun ? Un enfant vaut-il plus qu’un vieux ? Un groupe plus qu’un individu ?

Ce qui, dans le cas humain, restait un brouillard d’instincts, devient avec le robot une ligne dans un cahier des charges. On ne peut plus se cacher derrière “il n’a pas eu le temps de réfléchir”, parce que justement, la machine, elle, a été programmée pour y réfléchir avant. La douleur éthique arrive après, quand la réalité rattrape la théorie : une voiture s’est déportée pour éviter un piéton, et le passager est mort. Ou bien la voiture a maintenu sa trajectoire pour protéger son passager, et la vieille dame a été tuée. Dans les deux cas, quelqu’un pourra légitimement demander : qui a décidé que ma mère, mon enfant, mon conjoint devait être sacrifié dans ce scénario-là ? Et on ne pourra plus répondre : « c’est la malchance ». Il faudra dire : « c’était ce que la machine était censée faire dans ce cas de figure ». Ce n’est plus un accident, c’est une conséquence d’architecture.

On pourrait être tenté de répondre : au fond, les robots sont plus éthiques que nous. Ils ne boivent pas, ne s’endorment pas, ne regardent pas leur téléphone, ne s’énervent pas dans les embouteillages. Ils respectent les limitations de vitesse, les distances de sécurité, ils ne se vengent pas du type qui les a doublés un peu trop serré. Si on reste sur le plan des résultats globaux, oui, il est probable que des voitures autonomes généralisées feraient infiniment moins de victimes que notre zoo d’automobilistes en liberté. On peut très bien imaginer des statistiques où les morts sur la route s’effondrent, où les blessés sont divisés par dix. Objectivement, on y gagnerait en vies, en souffrances évitées, en milliards économisés.

Mais à côté de ça, on importe un autre type de problème, plus sournois. L’éthique de la machine ne tombe pas du ciel, elle est écrite par des ingénieurs, validée par des managers, négociée avec des assureurs, encadrée – espérons-le – par des régulateurs. Elle est alimentée par des données d’entraînement qui ont leurs biais, leurs angles morts, leurs oublis. Et surtout, elle est opaque. Tant que tout se passe bien, personne ne se pose de question. Le jour où un choix tragique arrive et fait la une, tout le monde voudra savoir : pourquoi la voiture a-t-elle tourné à droite plutôt qu’à gauche ? Pourquoi a-t-elle protégé celui-ci plutôt que celui-là ? Qui a décidé que c’était la “bonne” décision ? Le constructeur ? L’État ? Un comité d’éthique ? Un algorithme optimisant froidement une fonction de coût ?

C’est là que la comparaison avec l’humain devient vraiment dérangeante. Nous acceptons, à contrecœur mais massivement, que des humains se tuent entre eux sur la route. Nous vivons avec l’idée que conduire est un acte de liberté qui a un prix : des morts, des blessés, des vies brisées. Nous avons construit tout un imaginaire autour de ça : la vitesse, la maîtrise, l’accident, la fatalité. En revanche, nous sommes beaucoup moins disposés à accepter l’idée qu’un code, quelque part, ait décidé à notre place de qui devait mourir dans un croisement malheureux. Même si, statistiquement, ce code a évité cent autres drames.

Alors on fait quoi ? On garde la conduite humaine comme norme, avec son cortège de carnage annuel, au nom de la liberté, de la responsabilité individuelle, de l’idée rassurante que “c’est la vie” ? Ou bien on accepte de déléguer massivement la conduite à des systèmes qui, globalement, feront beaucoup mieux que nous, mais nous obligeront aussi à regarder en face une vérité très inconfortable : dans certains cas, ce ne sera plus nous, en tant qu’individus, qui aurons “mal réagi”, ce sera la société, via la machine, qui aura tranché.

Peut-être que la vraie ligne de fracture est là. Tant que les morts sont “absurdes”, “accidentelles”, produites par la faiblesse humaine, on parvient à les intégrer culturellement. À partir du moment où ils deviennent le résultat d’un arbitrage programmé, même s’il est rare, même s’il sauve globalement des milliers de vies, ils changent de statut. Ils deviennent politiquement explosifs. On passe du drame individuel à la responsabilité collective.

Entre le mur et la vieille dame, le robot ne “choisira” pas au sens humain du terme. Mais quelqu’un, quelque part, aura fait ce choix pour lui, en écrivant la règle. Et c’est peut-être ça, au fond, qui nous terrorise davantage que les chiffres des morts sur l’autoroute : l’idée qu’il faudra un jour assumer explicitement ce que nous avons toujours repoussé dans le flou du mot “accident”.